VPS Anbieter Unterschiede und Werbeversprechen – Contabo, Strato, Ionos, Netcup [Kommentar]

Mein letzter VPS Serververgleich liegt schon ein paar Jahre zurück. 2020 hatte ich Strato und Contabo im getestet. In den letzten Wochen habe ich wieder einen Vergleich zwischen verschiedenen Anbietern (Strato, Contabo, Ionos und Netcup) durchgeführt und wie auch schon 2020 gibt es recht viele Unterschiede zwischen den Anbietern, die man bei oberflächlicher Betrachtung der Rahmendaten (Virtuelle CPU Kerne, RAM, Speicherplatz) nicht vermutet.

Nachdem ich beim letzten Vergleich schon meine Erfahrungen mit Virtuozzo Virtualisierung gemacht hatte, habe ich dieses mal vorher geprüft, ob die Anbieter KVM nutzen.

Unterschiede in Kurzform:

| Strato (VC1-1) | Netcup VPS 200 G10 | Contabo VPS-XS, VPS-S, VPS-L (sowohl AMD als auch Intel und SSD und NVMe) | Ionos VPS XS | |

| generische Anbieterdomain | Nein | Ja | Ja | Nein |

| Rettungssystem | Ja, Gparted 1.4.0 (sehr gut) | Ja, aber quasi unbrauchbar, da vollkommen veraltet, GPARTED 0.25 | Ja, mehrere Qualität ok, aber verbesserungsfähig | Nein |

| IPV6 | nur eine Adresse | Ja, beliebig viele | Ja, beliebig viele | Nein |

| Beliebige Images | Nein | Ja | Nein | Nein |

| Snapshots | Nein | Ja, Online mit Warnungen und Offline, es wird Serverspeicherplatz genutzt, das wird aber vom gehosteten Linux nicht erkannt (gefährlich), man kann zwischen Snapshots vor und zurück wechseln, mit verschlüsselten Laufwerken kann man die Platznutzung durch Snapshots nicht erkennen | Ja, ohne Nutzung des Serverspeicherplatzes, Rollback löscht folgende Snapshots | Nein |

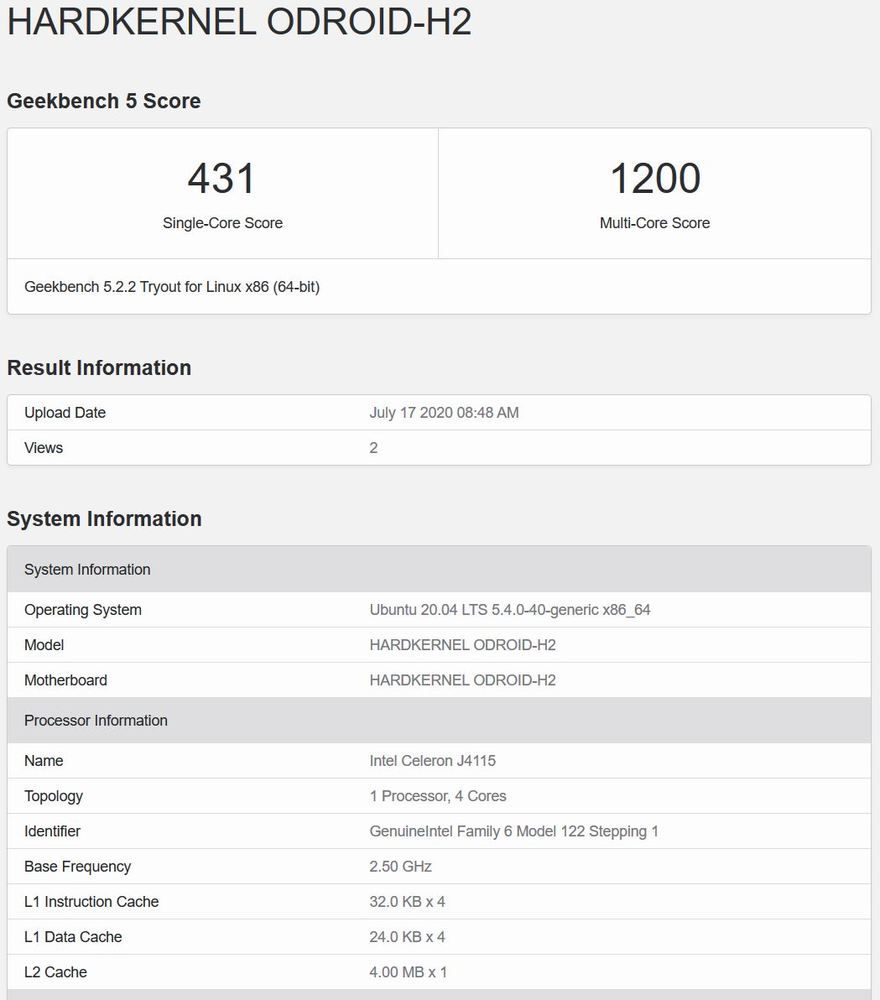

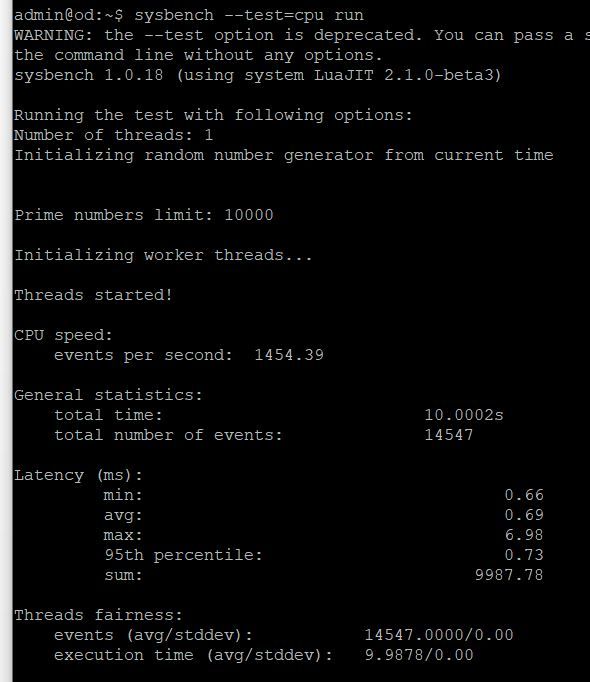

| Performanz 1 Kern Sysbench (Limit 10000) | 2863 | 701 | Intel 683 / AMD 1582 | 3170 |

| Multicore pro Kern Sysbench (Limit 50000) | 336 | 115 | Intel 135 / AMD 198 | 352 |

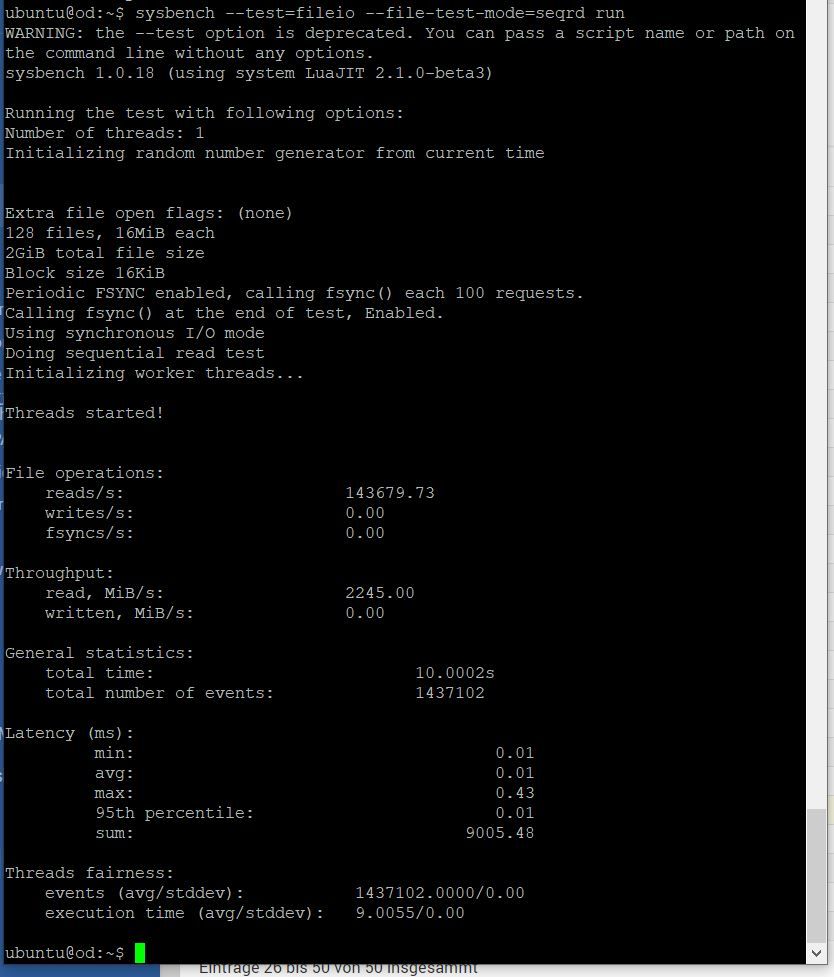

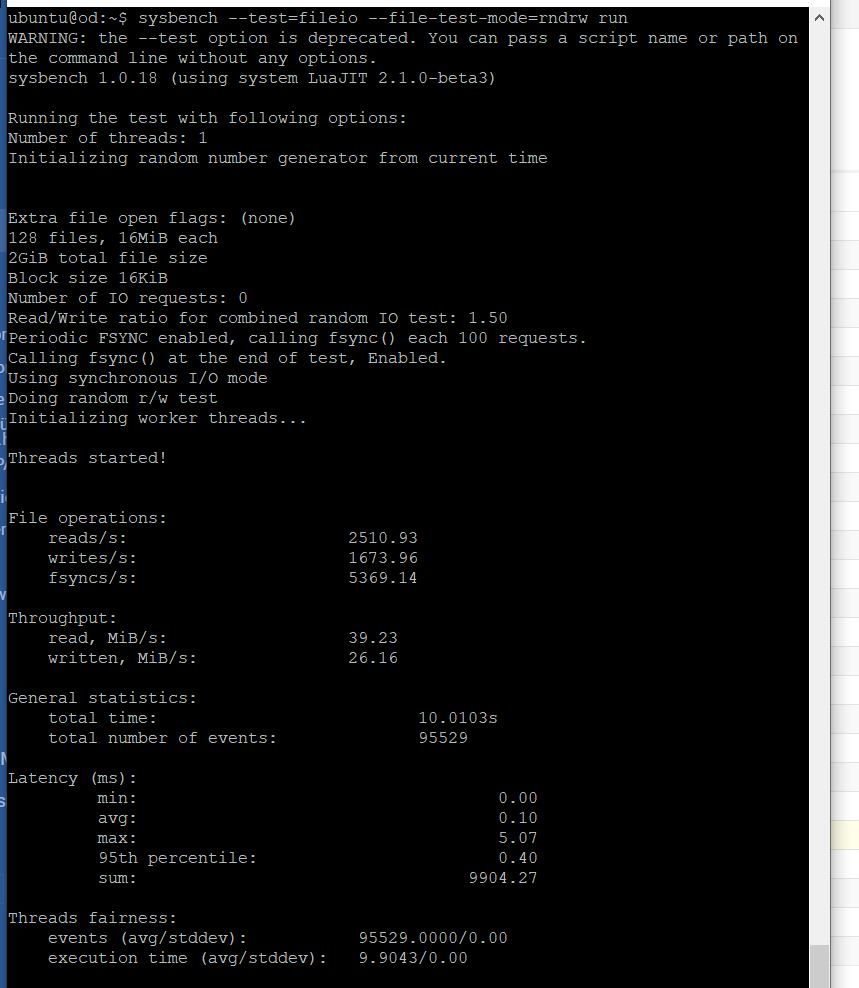

| IO Random Read / Write – Read Anteil | Anfangs, 150. dann 50 | 29 | 39 | 125, vermutlich analoger Abfall wie bei Strato |

| IO Random Read / Write – Write Anteil | Anfangs 90 dann 30 | 19 | 26 | 83 vermutlich analoger Abfall wie bei Strato |

| Virtualisierung | KVM | KVM | KVM | KVM |

| Voller Root Zugriff | Nur theoretisch, Linux verhält sich atypisch (die boot Partition lässt sich nicht ändern, Cloud Init und Zusatzskripte, bei Installation von Anwendungen) | Ja | Ja | Ja |

| Konsolenzugriff | Browser | Separates browserbasiertes Fenster (deutlich besser als bei Strato und Ionos) | Beliebige VNC Software, deaktivierbar | Browser |

| Zusätzliche Firewall vor Server | Ja | Ja | Nein | Ja |

| Identische Plattform | Config Files mit Namen Ionos, Performanz ist identisch | – | – | Siehe Strato |

| Plesk enthalten | Ja | Nein | Nein | Ja |

| Reverse DNS | Nur IPV4!, somit heutzutage unbrauchbar. Mit nerviger A Record Prüfung, wenn man mehrere Server IP Adressen für eine Domain nutzt, ist es Glückssache, ob es funktioniert | nicht getestet | IPV4, IPV6 freie Einträge | nicht getestet |

| Einrichtungsprozess | Recht flott | relativ flott aber nur mit vorherigem Anruf, vorher erfolgt keine Einrichtung, somit ist die Einrichtung immer ein manueller Prozess (zumindest beim ersten Server) | Recht flott, so lange man keine Sonderwünsche hat, die manuelle Bearbeitung kann Tage dauern | Recht flott |

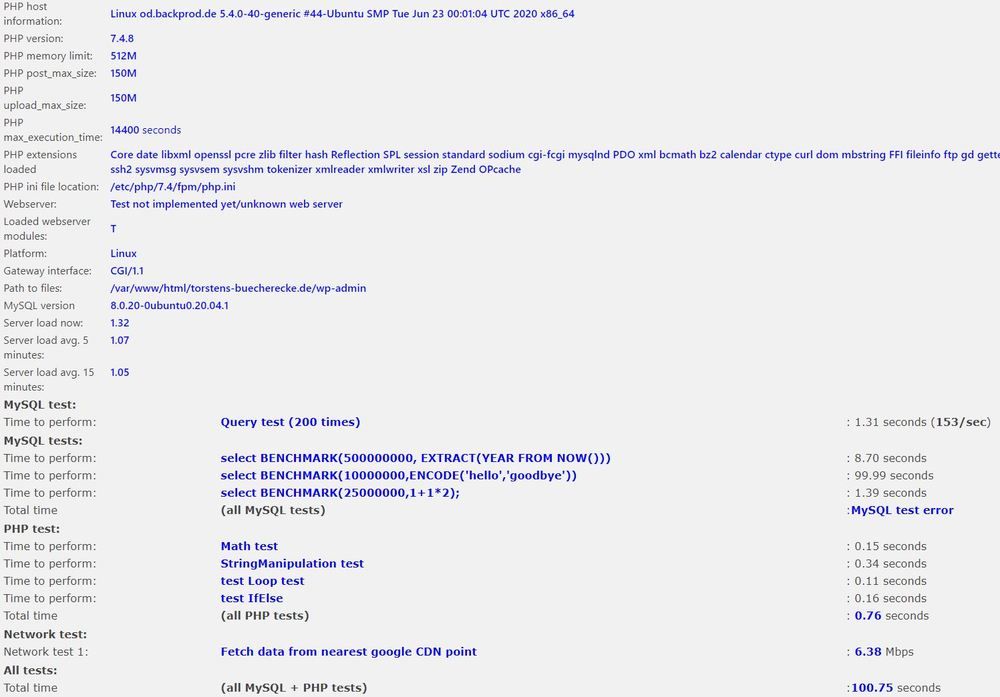

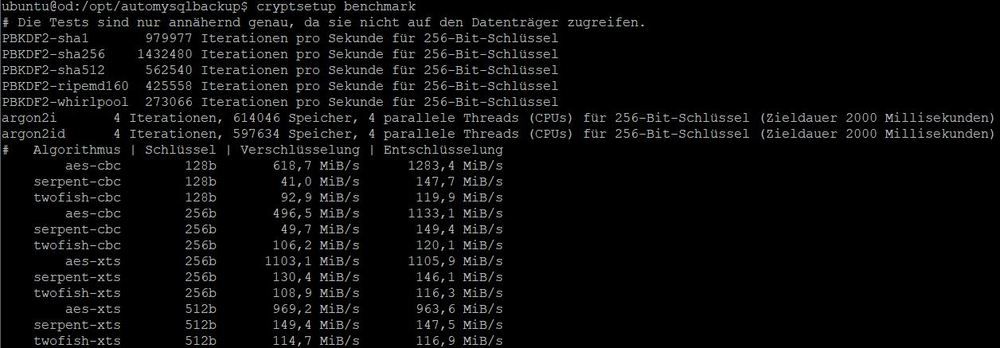

Performanz:

V Kerne

Was man an obigen Beispielen sieht, ist dass man den Vergleich der CPU Kerne nur innerhalb eines Anbieters nutzen kann. Contabo bietet zwei Plattformen (AMD und Intel). Die Intel Plattform beruht auf einer älteren Generation von Servern. Das heißt die alte Generation von Intel Prozessoren bietet gerade mal ein viertel der Leistung der Plattform die Ionos / Strato für die Virtualisierung nutzt.

Das bedeutet bei der alten Generation von Contabo ergibt sich ein Verhältnis von Faktor 4 zu der aktuellen Generation der CPUs von Strato / Ionos. 4 Kerne auf der Intel Architektur bei Contabo entsprechen einem Kern bei Strato / Ionos. Das gleiche gilt für Netcup, die offenbar auch eine recht alte Architektur nutzen. Bei der AMD Architektur von Contabo ist es noch Faktor 2, der Contabo von Ionos und Strato trennt. Als Kunde von Contabo zahlt man für beide Architekturen das gleiche, bekommt mit AMD aber die doppelte Leistung.

Kern Überbuchung

Wie auch schon beim letzten Test sind V-Kerne keine physischen Kerne, sondern nur Hyperthreading Kerne. Der Kunde bekommt somit die Leistung eines halben CPU Kerns.

Generell gilt, dass die VPS Überbucht sind. Das heißt der Anbieter verkauft mehr Kerne als die Prozessoren haben. Wenn alle Kunden somit gleichzeitig die Leistung abrufen, wird man weniger bekommen als einem rechnerisch zusteht. Wie stark die Anbieter überbuchen weiß man als Kunde nicht.

Faktisch kann es also passieren, dass man deutlich weniger Leistung erhält als gedacht. Die Anbieter versuchen im Marketing den Eindruck zu erwecken, dass es nicht so ist aber wenn man zwischen den Zeilen liest, erkennt man schnell die Unterschiede. Einige Anbieter bieten auch Virtuelle Server, bei denen einem Leistung dediziert zusteht. Das ist bei VPS V-Kernen nicht der Fall.

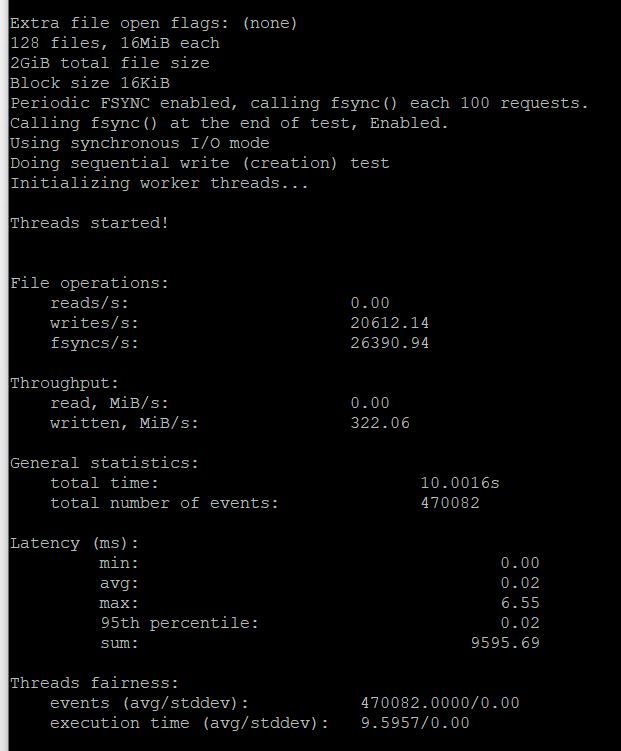

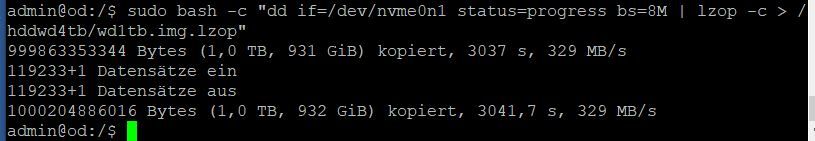

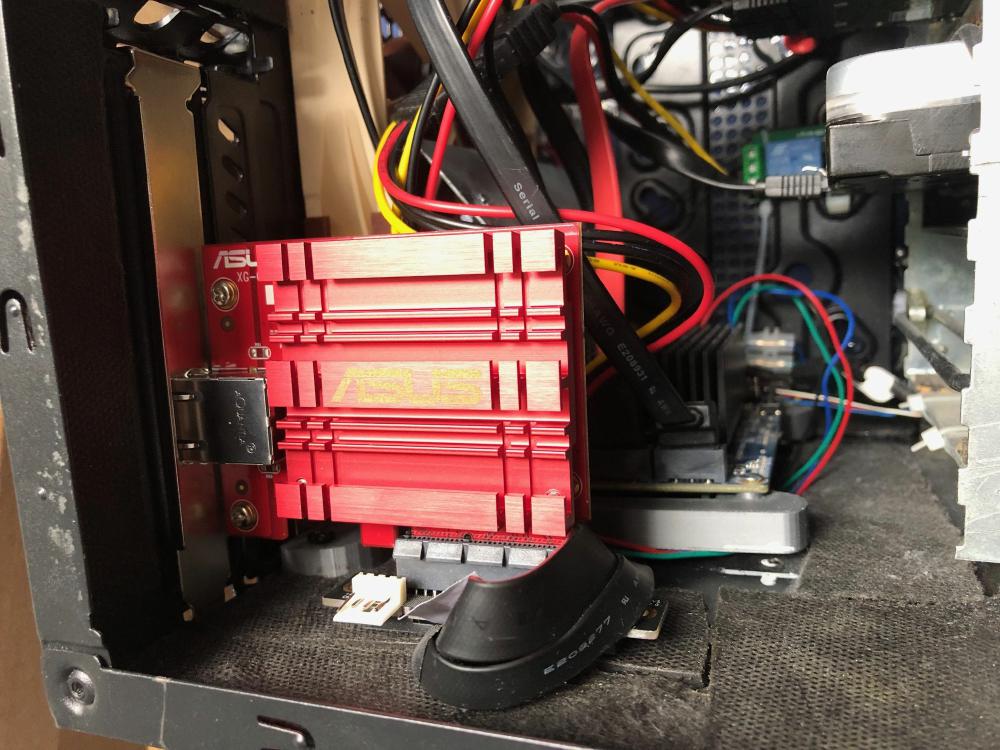

SSD vs. NVMe

Wie man an obigen Beispielen sieht kann man den Unterschied getrost als Marketing abtun. Ich habe bei Contabo einen VPS mit NVMe Speicher gebucht, der langsamer war als die SSD Server bei Random Read und bei Ionos / Strato hatte ich auch NVMe Speicher, die nicht viel schneller waren als die von den SSD Servern. So gesehen ist das Marketing der Anbieter recht dreist, wenn beim Kunden (fast) nichts von der vermeintlichen Mehrleistung ankommt.

Generell ist das was die Anbieter als SSD Leistung anbieten viel langsamer als alles was man zu Hause im eigenen Rechner nutzt. Selbst eine per USB3.0 angebundene SATA SSD ist locker doppelt so schnell als die Anbindung in allen VPS Servern, die ich getestet habe. Dabei ist es egal, ob es sich um NVMe oder SSD Server handelt.

Bei neuen VPS befindet man sich oft als erster Kunde auf der Hardware und somit hat man die volle Leistung für sich alleine. Das pendelt sich aber recht schnell ein und dann sinkt die Performanz in der Regel erheblich.

Performanzfazit

Faktisch muss einem klar sein, dass die Performanz von VPS Servern deutlich schwanken kann, dafür sind sie auch etwas günstiger als dedizierte Hardware oder dedizierte virtuelle Server. Bei Contabo habe ich mit diversen VPS getestet, insofern kann man schon grobe vergleiche ziehen. 20% sind aber durchaus eine mögliche Schwankungsbreite bei der Geschwindigkeit.

Support / Hilfe:

Ionos und Strato haben bei meinem Test recht schnell reagiert, wenn auch mit eher durchwasener Qualität. Bei Ionos hat man vermeintlich einen persönlichen Ansprechpartner, geantwortet haben aber immer andere Personen. Der persönliche Ansprechpartner ist primär Marketing.

Bei Contabo hat durch die massive Expansion der Support stark gelitten. Aktuell ist es eine Glücksfrage, ob man qualifizierten Support bekommt.

Bei Netcup hatte ich abseits der Einrichtung keinen Kontakt zum Support.

Die Hilfeseiten / Dokumentationen sind bei allen Anbietern durchwachsen. Bei Strato, Ionos war die Hilfe teilweise vollkommen veraltet, nicht passend zum Produkt oder es gab verschiedene Einträge, bei denen die Produktzuordnung vollkommen unklar war.

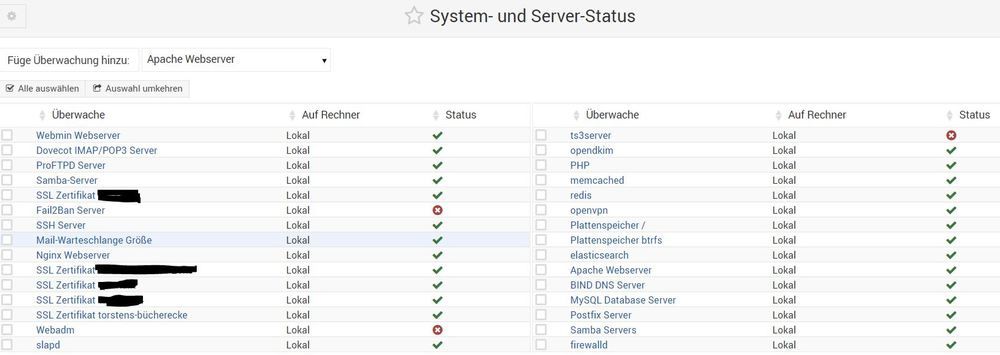

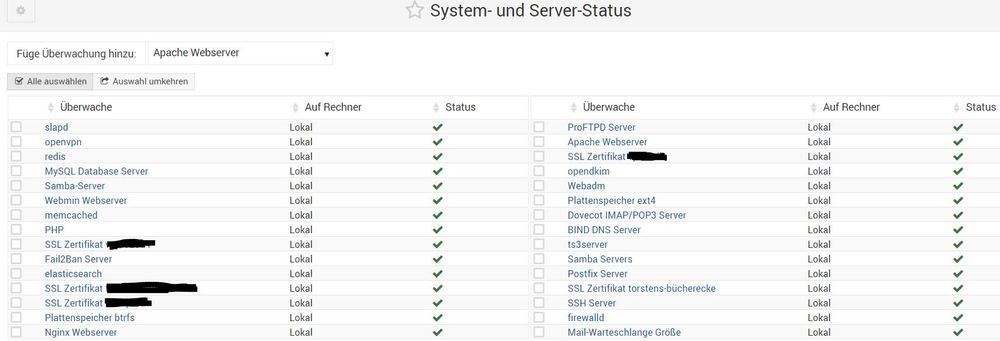

Verfügbarkeit:

Bei Contabo weiß ich durch mehrere Server und da ich seit einigen Jahren Kunde bin, dass Downtimes extrem selten sind. Unangekündigte Downtimes hatte ich noch nie. Bei Strato bin ich nun auch Kunde und werde die Situation länger beobachten, bisher ist mein Minijumphost aber stabil.

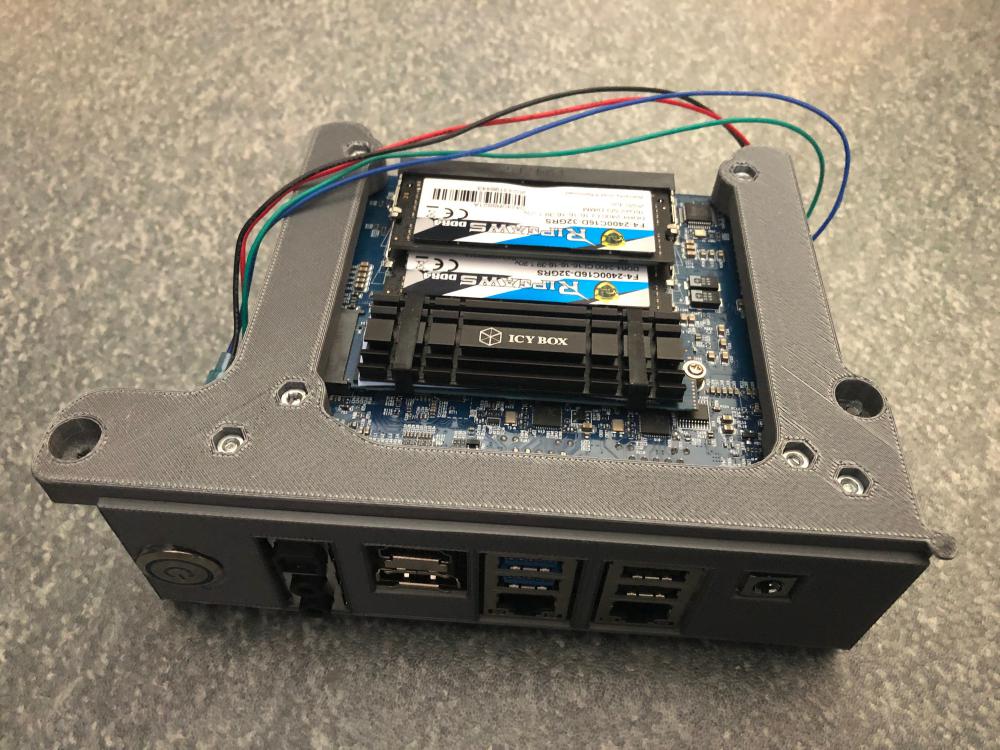

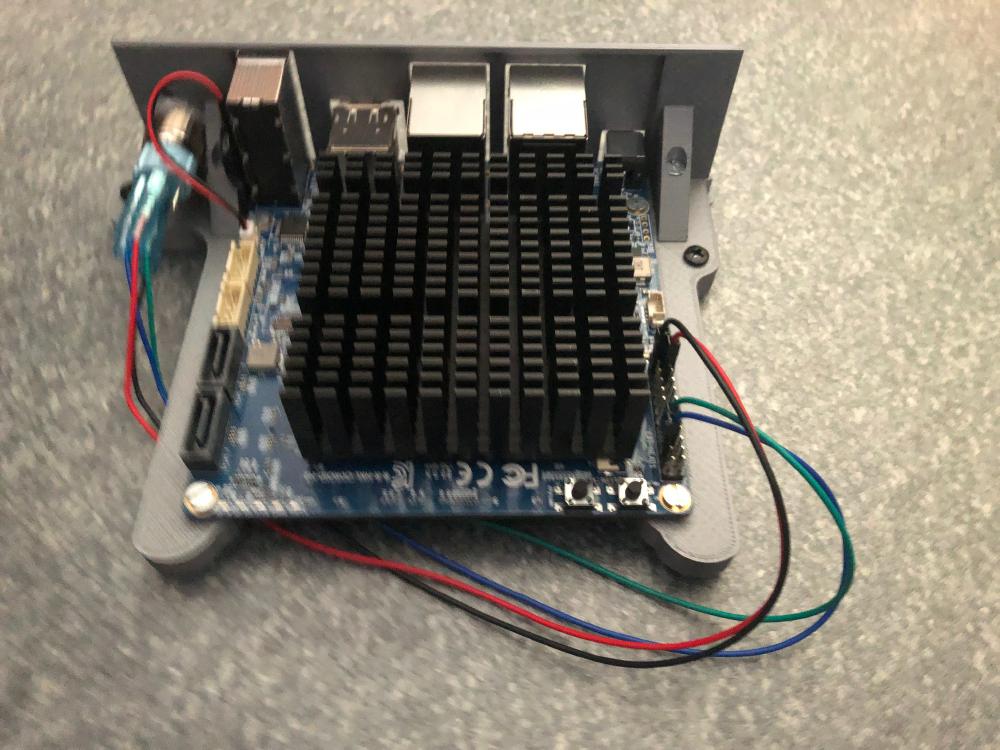

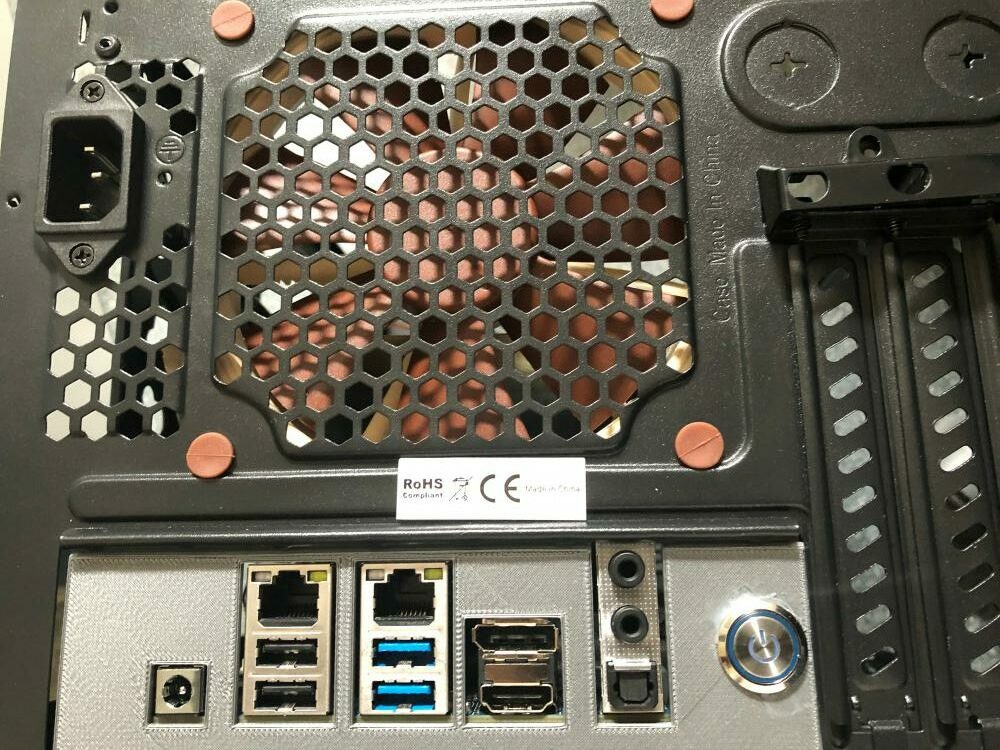

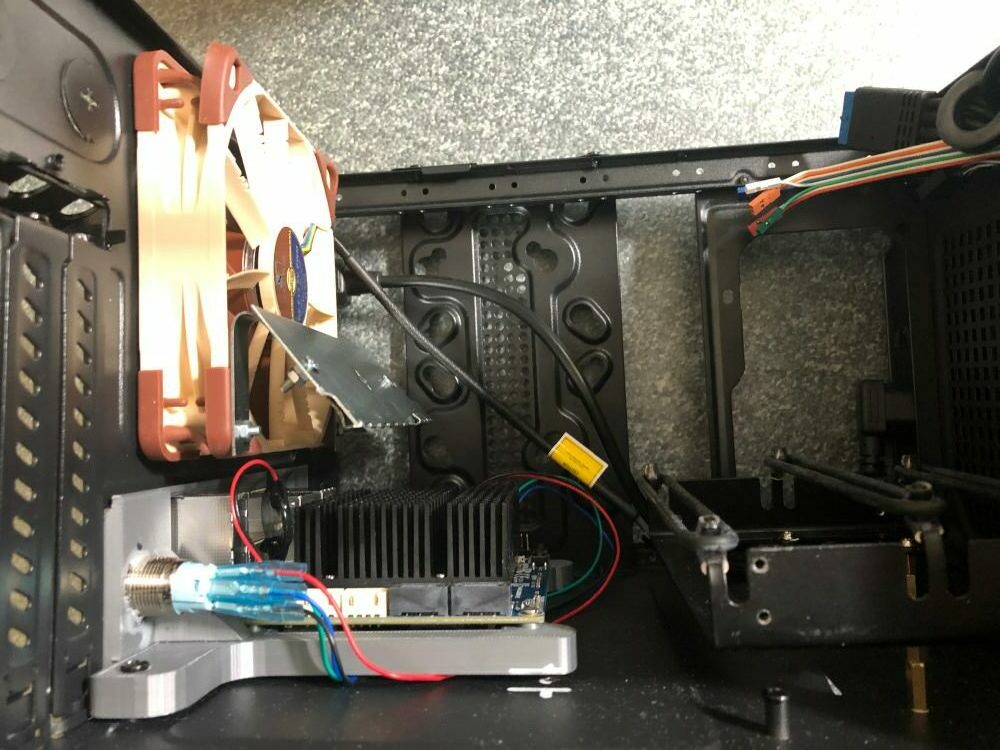

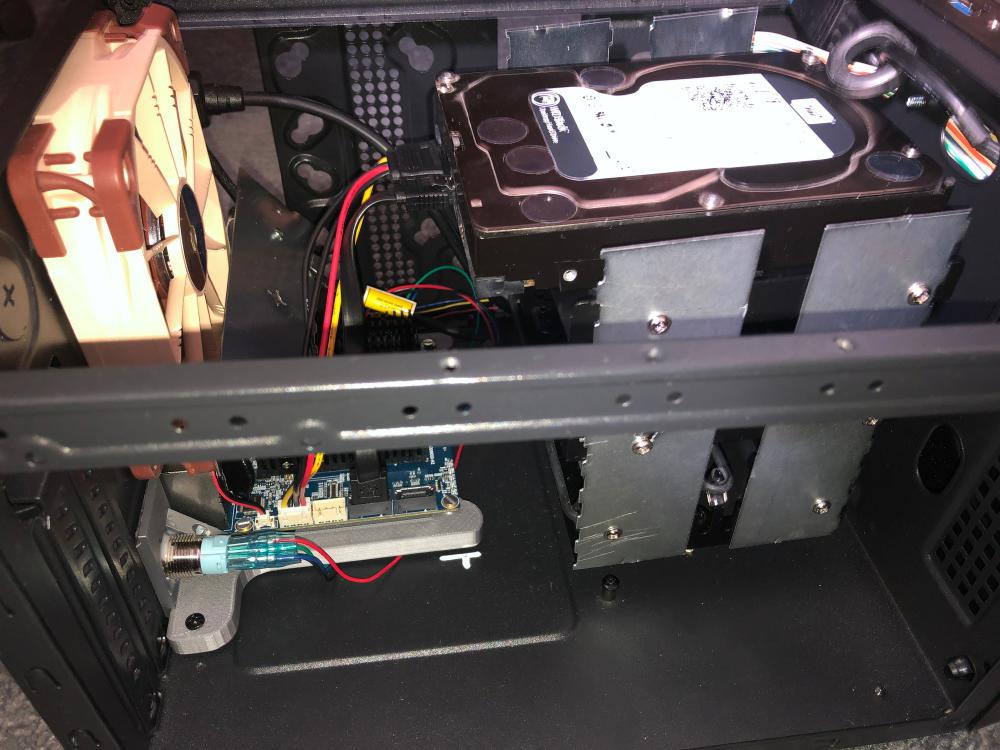

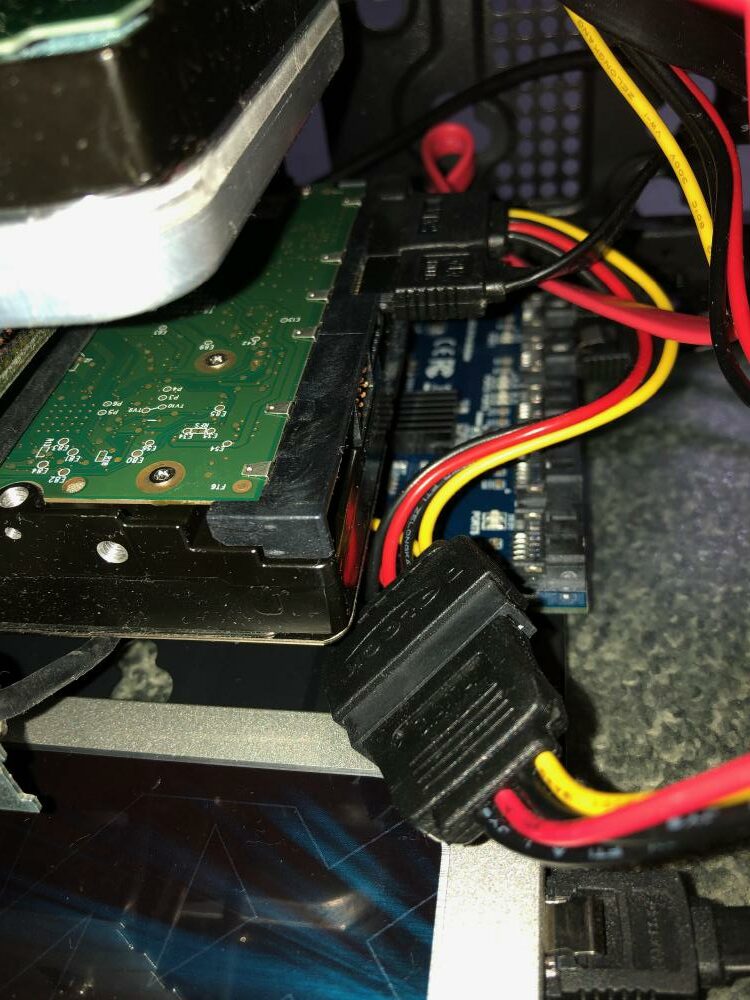

Eigener Server zu Hause:

Eine weitere Möglichkeit ist der Betrieb eines Server zu hause am eigenen Anschluss. In der Regel erlaubt euch das euer Festnetzvertrag nicht. Das vorweg, so lange ihr aber keine sehr hohen Datenraten habt, wird das ggf. nicht auffallen, wenn ihr an einen Webserver am Privatanschluss betreibt und keine sehr hohen Besucherzahlen habt.

Diese Variante würde ich aber nur empfehlen, wenn ihr einen recht schnellen Internetanschluss am besten Glasfaser mit hohen Uploadraten habt. Ansonsten fühlt sich eure Webseite sehr langsam an.

Die Komplexität ist bei dieser Variante aber höher, da ihr keine feste IP Adresse habt und moderne Anschlüsse teilweise nur noch IPV6 Adressen bieten, müsst ihr mehr Aufwand betreiben (Stichwort Jumphost mit VPS mit fester IPV4 / IPV6).

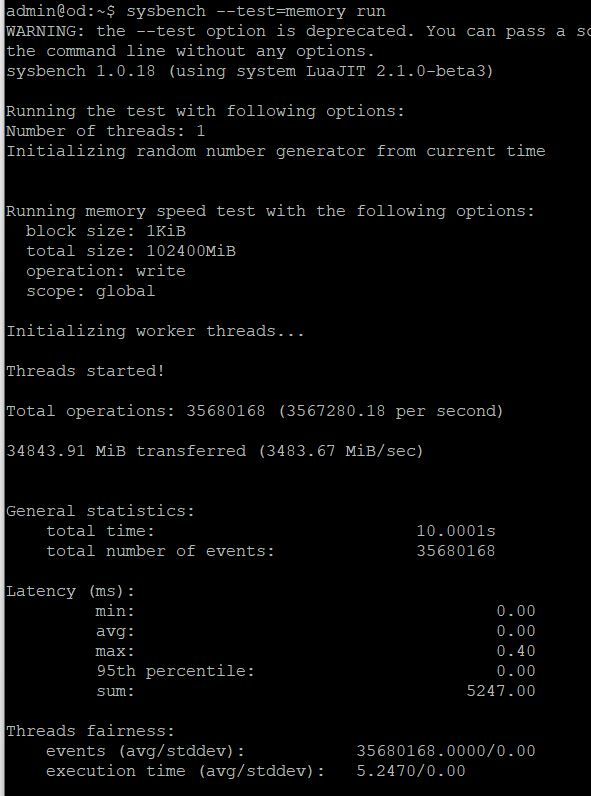

Günstiger ist die Variante bei den Stromkosten ggf. auch nicht immer, dafür könnt ihr frei die Hardware zusammenstellen. Ein Odroid H3 oder ein Raspberry Pi 5 können mit den VPS recht gut mithalten und bewegen sich bei den Stromkosten in einem überschaubaren Rahmen. Zuletzt hatte ich das mit einem Odroid H2+ oder dem Raspberry Pi 4 getestet, aktuell nutze ich einen Odroid H3 für diese Variante aber nur zum Testen und als Privatserver. Der Blog befindet sich nach wie vor auf einem VPS.

Ein weiterer Vorteil ist, dass ihr die Hardware nicht mit anderen Teilt. Aus Sicherheitsaspekten ist die Variante aber gefährlicher, weil Angreifer ggf. auch in euer Heimnetz kommen, wenn sie den Server kapern können (das kann man auch absichern mit doppelten Firewalls bzw. getrennten Netzzonen, treibt die Komplexität aber weiter nach oben).

Fazit:

Die Anbieter unterscheiden sich erheblich, obwohl die oberflächlichen Werbeversprechen sich stark gleichen.

Strato ist mit dem Wechsel von Virtuozzo nach KVM deutlich interessanter geworden, allerdings sind Themen wie kein “Reverse für IPV6” oder “nur eine IPV6” für mich nach wie vor Showstopper. Für Anfänger sind Themen wie Plesk als Administrationspanel ggf. auch ein Thema, da das den Einstieg in die Linux Welt erheblich vereinfachen kann.

Ich nutze mittlerweile Webmin oder direkte Linux Befehle aber das ist etwas in das man sich ohne Linux Kenntnisse erst einarbeiten muss und optisch ist Plesk schicker, wenn man auch eingeschränkter ist. Die Angebote für 1-2€ pro Monat sind bei Strato sehr gut, für einen WordPress Blog oder einen Webserver reicht der 2€ Server in der Regel locker aus und ist auch recht performant. Das man keine Snapshots hat, ist das für Anfänger aber eher problematisch. Strato hat aber aktuell mit Abstand die Performanzkrone (Ionos auch, aber da passt leider vieles andere nicht).

Ionos fand ich in diesem Vergleich enttäuschend. Dafür, dass sich der Anbieter als Partner für Unternehmen positioniert, ist das Angebot extrem schlecht. Es gibt kein Bootrettungsmedium, keine IPV6 Adressen und zusätzlich noch deutlich weniger Ressourcen zum gleichen Preis.

Für mich ist in Summe nach wie vor Contabo das beste Gesamtpaket, wenn man keine ganz kleinen Server will .

Wenn es mehr IP Adressen sein sollen (IPV6, Reverse Einträge und Snapshots, die gerade für Anfänger hilfreich sind), dann kommen Contabo oder Netcup in Betracht. Die Umsetzung von Snapshots bei Netcup finde ich aber seltsam bis gefährlich. Dafür besteht bei Netcup aber die Möglichkeit z.B. von ISO Images zu installieren. Das ist bei Contabo so nicht möglich und man muss mit Workarounds arbeiten, sofern man nicht die vorgegeben Images nutzen möchte (die sollten für Linuxinstallationen im Regelfall reichen, wer ausgefallenere Wünsche hat, z.B. Proxmox installieren ist ggf. bei Netcup besser aufgehoben).

Da zumindest bei meinem Testserver von Netcup die Preise höher und die Leistung schlechter war, ist das aber für mich aktuell keine Alternative. Darüber war ich überrascht, da die Kundenmeinungen über Netcap im Schnitt recht gut sind, basierend auf Performanz ist die Bewertung aber offenbar nicht erfolgt.